| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |

- computer vision

- 프로그래머스

- Python

- 내용추가

- 모두를 위한 딥러닝

- 백준

- reinforcement learning

- 알고리즘

- object detection

- coding test

- 논문

- Today

- Total

목록전체 (41)

NISSO

[Object Detection] Sliding Windows Detection

[Object Detection] Sliding Windows Detection

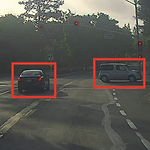

Sliding Windows Detection 이란 Sliding Windows Detection 방법 Sliding Windows Detection 단점 Sliding Windows Detection 구조 (구현) Sliding Windows Detection 객체 위치를 식별하는 object localization의 하나로, sliding window는 이미지에서 8이라는 객체 위치를 찾고 싶을 때, 그 객체를 찾을 때까지 모든 섹션을 확인해 탐지하는 방법이다. Sliding Windows Detection 방법 위와 같이 이미지에서 자동차 객체를 탐지하려고 한다. 1. 차가 있는 이미지에서 차가 아닌 부분을 자르고 차만 남긴다. 2. 이미지 x에 따라 레이블 y는 차 1, 차가 아닌 경우 0으로 설..

object detection 논문 흐름도

object detection 논문 흐름도

해당 논문들 https://github.com/hoya012/deep_learning_object_detection Object Detection in 20 Years (20년간의 Object Detection에 대해 연구한 논문) https://arxiv.org/pdf/1905.05055.pdf

[개념정리] IOU (Intersection Over Union)와 mAP (mean Average Precision)

[개념정리] IOU (Intersection Over Union)와 mAP (mean Average Precision)

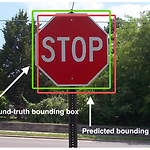

IOU Intersection over Union Ground-truth bounding box : 실제 객체 위치 Predicted bounding box : 내가 찾은 객체 위치 Intersection : 교집합. predicted bounding box와 ground-truth bounding box가 겹치는 부분 (overlap된 부분) Union : 합집합. predicted bounding box와 ground-truth bounding box를 모두 둘러싼 부분 Intersection Over Union (IOU) : Intersection을 Union으로 나눈 비율 즉, IOU는 모델이 얼마나 object detection을 정확히 했는지 정확도를 측정할 수 있는 지표다. HOG + 선형 ..

학습시 loss / val_loss가 비정상적으로 높을 때

학습시 loss / val_loss가 비정상적으로 높을 때

학습을 시키다가 loss: 7548178870.4000 val_loss: 194597683200.0000 와 같이 비정상적으로 높은 loss 값이 나왔다. 1 이하여야 하는 loss가 2도 아니고 왜이렇게 높은 건지.. 결과는 또 정상적으로 잘 나왔다. 이전엔 loss가 nan값이 나오기도 했다. 아무튼 loss 정상화를 위해 시도해본 것들을 써보려 한다. 1. batch_size batch_size를 높이라는 말이 있던데, 아쉽게도 OOM (Out Of Memory) 문제로 시도해보지 못했다. 2. optimizer의 learning rate learning rate를 낮추니 loss값이 줄어들긴 한다. 종류에 따라서도 다르다. * optimizer 종류와 parameter 참고 : https://ke..

[강화학습] Lec 01 : Introduction

[강화학습] Lec 01 : Introduction

David Silver 교수님의 Reinforcement Learning 강의 정리 https://youtu.be/2pWv7GOvuf0 강의 자료 https://www.davidsilver.uk/teaching/ 한국어 강의 https://youtu.be/wYgyiCEkwC8 (팡요랩) 기계학습은 지도학습, 비지도학습, 강화학습으로 나뉜다. 강화학습은 지도학습, 비지도학습과 다른 개념이란 것이다. * 그림에서 머신러닝은 셋의 교집합이 아니라 가장 큰 원 강화학습의 특징 supervisor 없이 reward만 존재 : 답을 알려주지 않고 보상만 받으면서 좋은 걸 찾아나감 ex) 로봇이 앞으로 가려면 발을 앞으로 내딛어야 한다는 정답을 알려주지 않음. 알아서 액션을 취하고 경험하면서 보상을 받음 피드백이 즉..

[모두를 위한 딥러닝] Lec 02 : Linear Regression의 Hypothesis와 cost

[모두를 위한 딥러닝] Lec 02 : Linear Regression의 Hypothesis와 cost

홍콩과기대 김성훈 교수님의 '모두를 위한 딥러닝' 강의 정리 http://hunkim.github.io/ml/ 모두를 위한 머신러닝/딥러닝 강의 hunkim.github.io X (공부한 시간) = 7 ↓ Regression ↓ Y (시험 점수) = 75 Linear Regression : 선형회귀 Linear Regression의 Hypothesis (가설) ex) 공부한 시간이 많을수록 시험 점수가 높다. ex) 집의 크기가 클수록 가격이 높다. 이러한 가설들은 아래와 같이 그래프에 선으로 표현할 수 있다. 이 중에 어떤 "선"이 이 데이터에 가장 잘 맞는 선인지 알아내는 게 Linear Regression이다. 이 선(가설)을 수학적으로 나타내면 H(x) = Wx + b 여기서 W와 b를 찾는 게 ..

홍콩과기대 김성훈 교수님의 '모두를 위한 딥러닝' 강의 정리 http://hunkim.github.io/ml/ 모두를 위한 머신러닝/딥러닝 강의 hunkim.github.io Machine Learning이란 Learning이란 - 지도학습 / 비지도학습 regression이란 classification이란 [ Machine Learning이란] - Limitations of explicit programming (명시적 프로그래밍의 한계) ex) 스팸 메일 필터링, 자율주행 : 너무 규칙이 많음 => 사람이 명시적으로 정해주지 않고 컴퓨터가 알아서 학습하는 것이 머신러닝이다. (Arthur Samuel, 1959) [ Supervised Learning (지도학습) ] 레이블이 정해져있는 데이터(tra..

홍콩과기대 김성훈 교수님의 '모두를 위한 딥러닝' 강의 정리 http://hunkim.github.io/ml/ 모두를 위한 머신러닝/딥러닝 강의 hunkim.github.io 앤드류응 교수님의 ML 수업 https://www.coursera.org/learn/machine-learning 을 듣고 어떤 분이 정리한 노트 http://www.holehouse.org/mlclass/ Visual Recognition을 위한 CNN http://cs231n.github.io (아마 가장 유명한 Computer Vision 강의인 cs231n) 딥러닝 이해에 필요한 (기본적인) 수학 : Linear Regression, Logistic Regression 강의 순서 Machine Learning Basic Co..